ChatGPT o Bing Chat tienen un fallo importante: nunca las uses para hacer esto

A lo largo de los últimos meses muchos hemos hecho todo tipo de pruebas en diferentes plataformas relacionadas con la Inteligencia Artificial como ChatGPT o Bing Chat. Normalmente confiamos en las informaciones y datos que nos proporcionan, algo en lo que quizá nos estemos equivocando.

Os contamos todo esto por qué en multitud de ocasiones utilizamos plataformas como las mencionadas, que se encuentran entre las más populares y usadas a nivel global, para conversar o generar textos automáticos. Además realizamos todo tipo de consultas a través de las cuales obtenemos respuestas más o menos completas dependiendo del prompt que usemos.

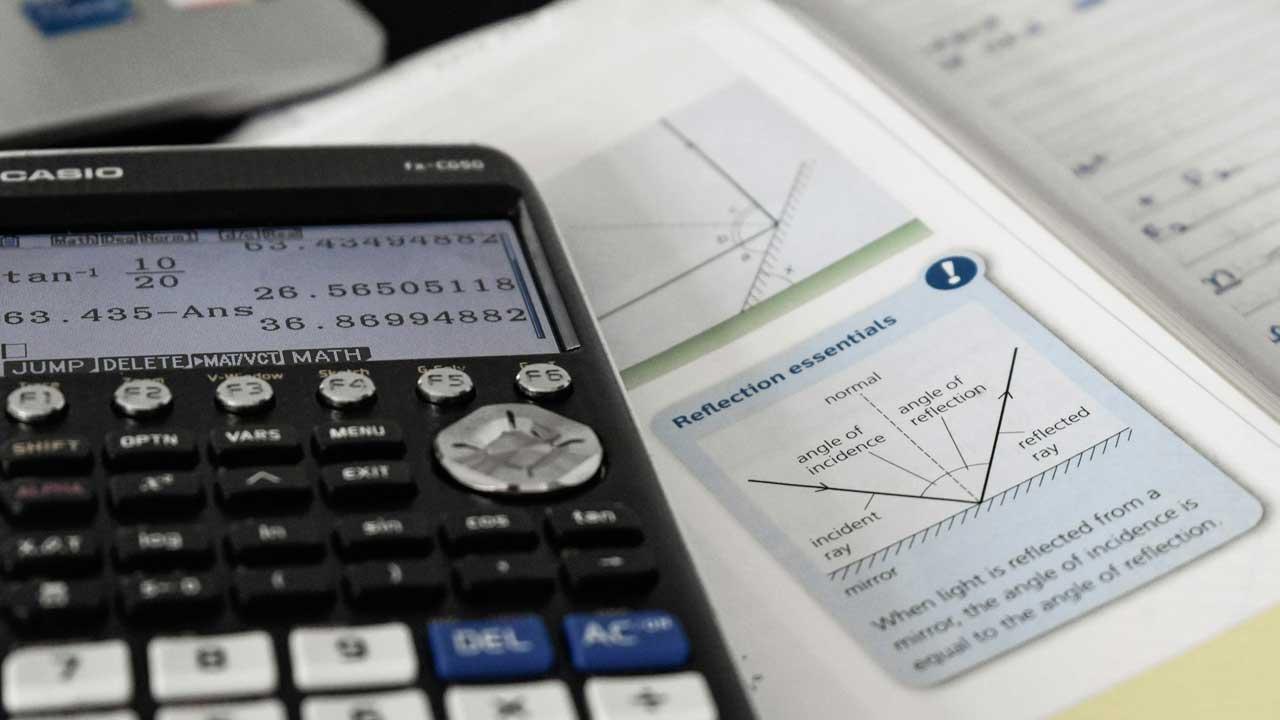

Sin embargo poco a poco nos vamos dando cuenta de que deberíamos ser un poco más precavidos con los resultados que nos proporcionan estas IA. Y no nos podemos centrar en estas dos solamente, nos referimos a la práctica totalidad de las aplicaciones y plataformas de Inteligencia Artificial que podemos usar ahora mismo. Un claro ejemplo de todo ello lo están comprobando muchos usuarios a la hora de utilizar estas aplicaciones con consultas relacionadas con cálculos matemáticos.

Ahora usuarios de todo el mundo se están dando cuenta de que modelos como Gemini de Google o ChatGPT, entre otras, tienen importantes fallos matemáticos a la hora de ofrecer resultados. Y es que lo primero que debemos tener en consideración es que los chatbots no son calculadoras precisamente. Debemos tener presente que a la hora de realizar consultas con un chat bot cualquiera, es preferible aportar la máxima información posible y elaborar cuidadosamente el prompt para obtener una buena respuesta.

No confíes en los resultados matemáticos de las IA

Es muy probable que en multitud de ocasiones que hayáis comprobado de primera mano los excelentes resultados que estos modelos de lenguaje nos proporcionan a la hora de generar textos automáticos. Pero como os decíamos antes, no son calculadoras. Y es que a la hora de solicitar la resolución de cálculos matemáticos o problemas más complejos relacionados con números, deberíamos comprobar bien los resultados obtenidos.

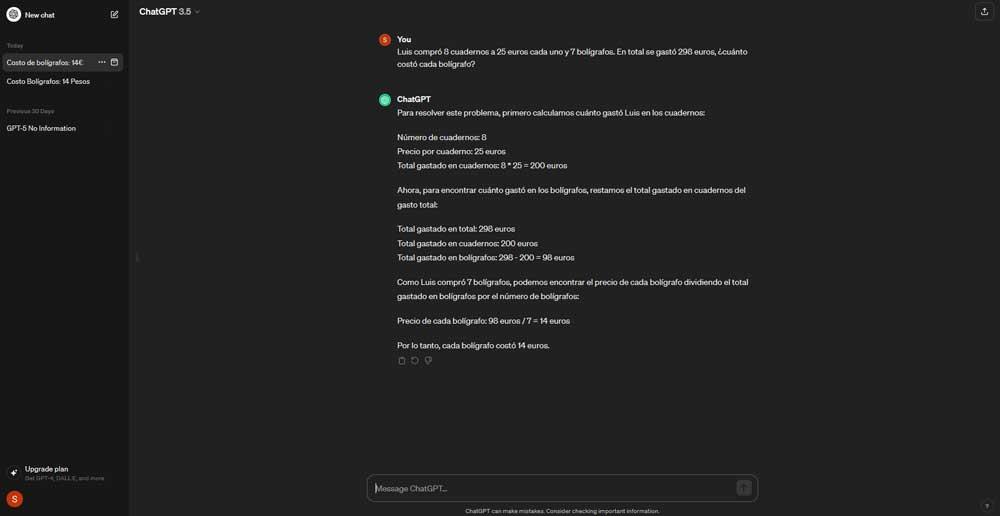

Os contamos todo esto porque, por ejemplo, multitud de usuarios han detectado que la propuesta más popular como es ChatGPT, también se equivoca. Esto es algo que se ha podido comprobar de en multitud de ocasiones a la hora de emplear la lógica o incluso realizando cuentas básicas.

Claro, muchos pueden pensar que solicitar a un modelo lingüístico que haga las veces de una calculadora, no es del todo justo. Quizás sería como pedirle a una calculadora que escriba una novela, no es el fin para el que se diseñó. De ahí que a la hora de solicitar a una IA centrada en los textos, cualquier cálculo matemático, deberíamos comprobar los resultados. Además esto es algo que se hace extensible a la gran mayoría de los modelos actuales, muchos de ellos pertenecientes a grandes empresas tecnológicas.

A su vez debemos tener presente que estos errores en los cálculos matemáticos y en el empleo de la lógica, los vamos a encontrar en los modelos más avanzados como GPT4, por ejemplo. Y no solo hablamos de complejas ecuaciones o cálculos retorcidos, sino que se han detectado errores incluso a la hora de realizar cuentas básicas de elementos o trabajar con datos numéricos en general.

No solo eso, sino que en ocasiones cuando señalemos el error a la IA, se disculpe y nos ofrezca una respuesta alternativa, tampoco será necesariamente correcta. En resumidas cuentas, estos modelos inteligentes son excelentes para crear textos automáticos, pero a la hora de realizar cálculos matemáticos y trabajar con números, deberíamos comprobar dos veces los resultados.